Nova anketa koju je provela AI sigurnosna kompanija Mindgard, na osnovu odgovora više od 500 stručnjaka za sajber sigurnost na konferencijama RSAC 2025 i Infosecurity Europe 2025, otkriva zabrinjavajući trend: čak i sigurnosni timovi, zaduženi za zaštitu organizacija, koriste AI alate bez odobrenja.

“Shadow AI” – Nevidljivi rizik unutar sigurnosnih timova

Slično kao fenomen shadow IT-a, gdje zaposleni koriste neodobrene aplikacije mimo IT odjela, shadow AI se odnosi na neautorizovanu upotrebu AI alata. No, rizici su još veći, jer ti alati često obrađuju:

- osjetljive kodove,

- interna dokumenta,

- podatke korisnika,

što povećava mogućnosti curenja podataka, kršenja privatnosti i neusklađenosti sa propisima.

Ključni nalazi istraživanja:

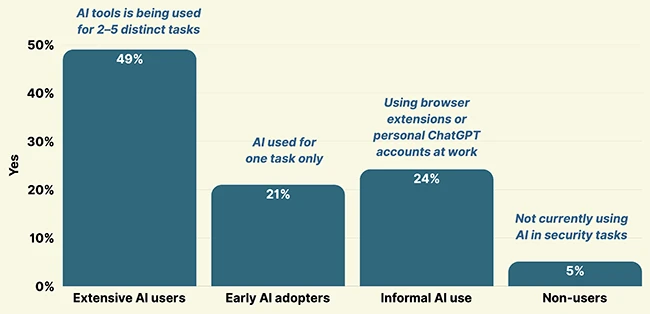

- 86% sigurnosnih stručnjaka koristi AI alate,

- 24% koristi lične naloge ili neodobrene ekstenzije pretraživača,

- 76% vjeruje da i njihove kolege to rade, najčešće za:

- pisanje pravila za detekciju prijetnji,

- kreiranje edukativnog sadržaja,

- pregled koda.

Vrsta unesenih podataka dodatno povećava rizik:

- 30% ispitanika je unosilo interna dokumenta i e-mailove,

- Isto toliko priznaje da su unosili podatke korisnika ili poslovne tajne,

- 1 od 5 je rekao da je lično unosio osjetljive informacije,

- 12% nije bilo sigurno šta je sve uneseno.

Stručna perspektiva: Panika nije rješenje, već – upravljanje

“Svaki upload osjetljivih podataka na treće strane – bilo da je to kod, fajl ili AI asistent – nosi rizik. Ali panika nije rješenje. Rješenje su: jasne politike, edukacija i dosljedna SaaS kontrola,”

— Steve Wilson, vođa OWASP GenAI Security projekta

Wilson ističe da pravi sigurnosni izazov nije samo shadow AI, nego kriza identiteta:

- kompromitovani nalozi,

- unutrašnje prijetnje,

- AI-napadi koristeći deepfake i spearphishing metode.

Nedostatak nadzora:

- Samo 32% organizacija prati korištenje AI-a,

- 24% se oslanja na neformalne metode poput anketa ili nadređenih,

- 14% nema nikakav nadzor, što znači da ne znaju šta se dešava s AI rizicima.

Ko je odgovoran za AI rizik?

- 39% ispitanika kaže da niko zvanično nije zadužen,

- 38% navodi sigurnosni tim,

- Ostali pominju data science, menadžment ili pravni tim.

Ova nejasnoća ukazuje na hitnu potrebu za koordinaciju među timovima i definisan plan odgovornosti.

Zaključak:

Organizacije moraju:

- uspostaviti politike za upotrebu AI-a,

- edukovati timove o sigurnom rukovanju podacima,

- povezati sigurnost, pravni sektor i IT odjele u zajednički okvir odgovornosti.

Bez jasnog nadzora, AI koji bi trebao pomoći, lako može postati prijetnja iznutra.

Izvor:Help Net Security